Собранные компанией данные являются фундаментальным источником информации для любого бизнеса. Извлечь искомое своими силами из огромного массива не так-то просто и здесь на помощь приходит специальный софт.

Перевод публикуется с сокращениями, автор оригинальной статьи Edwin Lisowski.

Apache Hadoop

Apache Hadoop – самый популярный инструмент для BigData. Позволяющий обрабатывать огромные объемы данных фреймворк с открытым исходным кодом (бесплатный по лицензии Apache) работает на мощном оборудовании в дата-центре.

Основные возможности:

- облачная инфраструктура;

- поддерживающие другие модели работы фреймворка библиотеки;

- универсальная модель для обработки – MapReduce;

- распределенная ФС – HDFS, позволяющая хранить любые типы данных;

- высокая масштабируемость;

- эффективная и гибкая обработка данных.

Apache Storm

Распределенный фреймворк реального времени, поддерживающий любой ЯП. Он написан на Java и Clojure и является полностью бесплатным. Apache Storm может обрабатывать и преобразовывать потоки данных из различных источников.

Основные возможности:

- отказоустойчивый и масштабируемый;

- может обрабатывать один миллион стобайтовых сообщений в секунду на каждом узле;

- интегрируется с любым ЯП;

- обеспечивает обработку каждой единицы данных (минимум один раз точно).

RapidMiner

RapidMiner – это кросс-платформенный инструмент для обработки BigData с открытым исходным кодом. Он объединяет data science, прогнозную аналитику и технологию машинного обучения, а также предлагает широкий спектр продуктов, позволяющих создавать новые процессы интеллектуального анализа данных.

Платформа доступна под различными лицензиями: бесплатная позволяет пользователям использовать 1 логический процессор и до 10 000 строк данных; стоимость коммерческой версии Rapidminer начинается с $2.500 в год.

Основные возможности:

- хорошо развитая облачная интеграция;

- интерактивные информационные панели, которые легко расшарить;

- интеграция с клиентскими базами данных;

- создание и валидация прогнозных моделей;

- разнообразие методов управления данными;

- прогнозная аналитика на основе BigData;

- поддержка клиент-серверной модели.

Qubole

Основываясь на вашей деятельности, автономная BigData-платформа Qubole изучит, оптимизирует и сможет управлять данными. Это положительно скажется на сосредоточенности инженеров исключительно на обработке данных вместо управления фреймворком.

Стоимость инструмента от $199 в месяц, но есть вариант подписки, предназначенный для предприятий с несколькими пользователями.

Основные возможности:

- облачная оптимизация;

- гибкость и простота в использовании;

- движок с открытым исходным кодом;

- автоматическое использование процедур, для минимизации повторения ручных действий;

- встроенные оповещения и рекомендации, оптимизирующие надежность, производительность и затраты на обслуживание.

Tableau

Tableau – инструмент визуализации для бизнес-аналитики и анализа данных. Программное обеспечение содержит три основных продукта: desktop, server, online предназначенные для аналитики, предприятия и использования в облаке соответственно.

Проект прост в использовании, может обрабатывать все размеры данных, а также умеет визуализировать данные в реальном времени через web-коннектор.

Tableau предлагает бесплатную пробную версию. Подписка начинается от $35 в месяц, в зависимости от издания (desktop/server/online).

Основные возможности:

- совместная работа онлайн;

- создание любых типов визуализации;

- no-code запросы;

- простое расшаривание данных для мобильных устройств;

- удобная настройка.

Cassandra

Распределенная опенсорсная БД Cassandra, предназначена для управления большими объемами данных, раскиданных по серверам. Распространяется бесплатно.

Основные возможности:

- быстрая обработка огромных объемов данных;

- линейная масштабируемость;

- доступ из облака;

- отсутствие единой точки отказа;

- автоматическая репликация;

- распределение данных между дата-центрами.

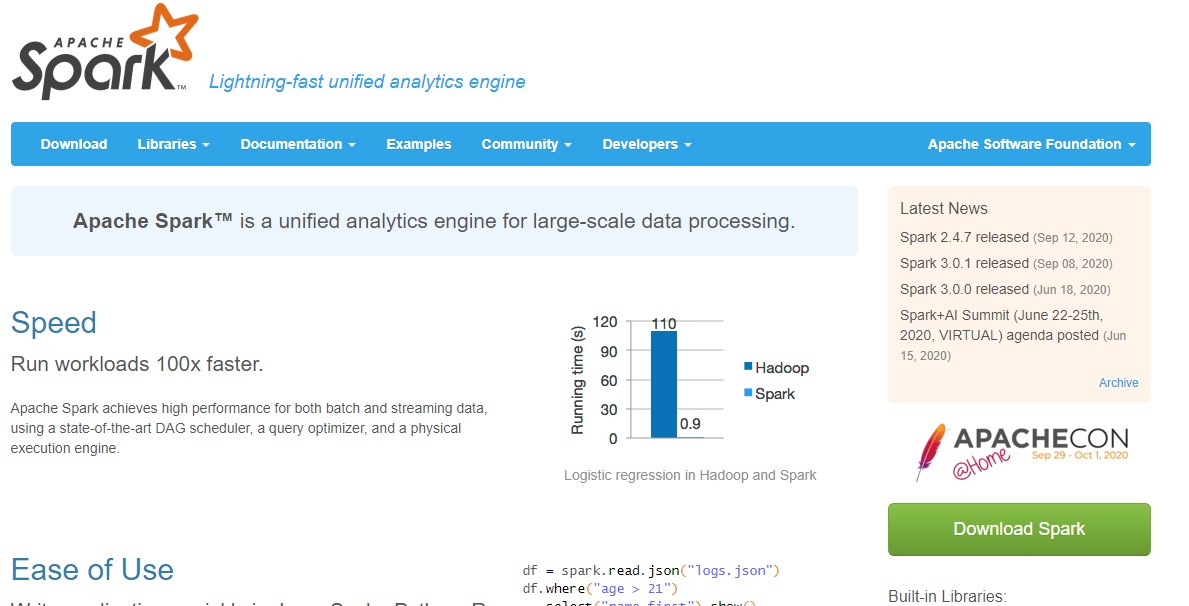

Apache Spark

Apache Spark – это уникальное решение с открытым исходным кодом, способное обрабатывать как данные реального времени, пакетные данные, так и данные в памяти, что обеспечивает быстрые результаты. Инструмент может работать в локальной системе, что облегчает тестирование и разработку. Стоимость завязана на лицензии Apache, но есть и бесплатная пробная версия.

Основные возможности:

- производительная потоковая обработка;

- интеллектуальная система обработки графов;

- автономный кластерный режим;

- стек доступных тематических библиотек;

- DataFrame API;

- развертывание в облаке.

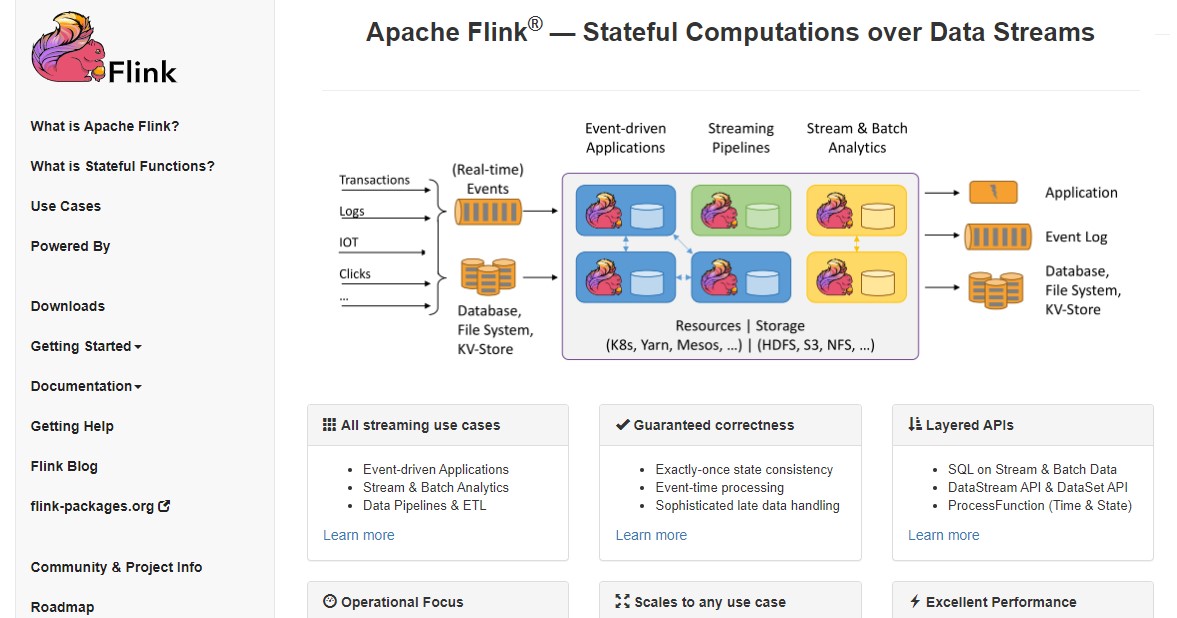

Flink

Фреймворк с открытым исходным кодом для потоковой обработки больших данных. Она может быть как ограниченной, так и неограниченной. Flink работает во всех известных кластерных средах и способен продуктивно выполнять задачи любого масштаба.

Основные возможности:

- точные результаты;

- отказоустойчивость и авто-восстановление после сбоя;

- поддержка различных адаптеров для связи со сторонними системами и источниками данных;

- гибкость «оконного» управления.

Заключение

При наличии множества инструментов для работы с BigData, важно четко определить свои потребности, прежде чем выбрать подходящий под структуру вашего бизнеса.

Поскольку большинство платформ предлагают пробную версию, рекомендуется уделить время тщательной проверке, чтобы они полностью соответствовали вашим требованиям.

Разнообразие продуктов велико, выберите свой для повышения производительности, точности результатов и уменьшения скучной рутины. Если вы используете в проектах другой софт – напишите в комментариях, какой именно и ваше мнение о нем.

Какие продукты и сервисы для работы с большими данными используются в вашей компании?