Текст публикуется в переводе, автор оригинальной статьи – Robert Lange.

Вы ищете лучший обзор различных отраслей глубокого обучения, которые в данный момент активно разрабатываются исследователями? У вас открыто гораздо больше закладок arXiv, чем вы можете прочитать? Слишком мало времени, чтобы смотреть видео целиком? Вот если бы была краткая сводка ключевых идей и концепций этих статей!

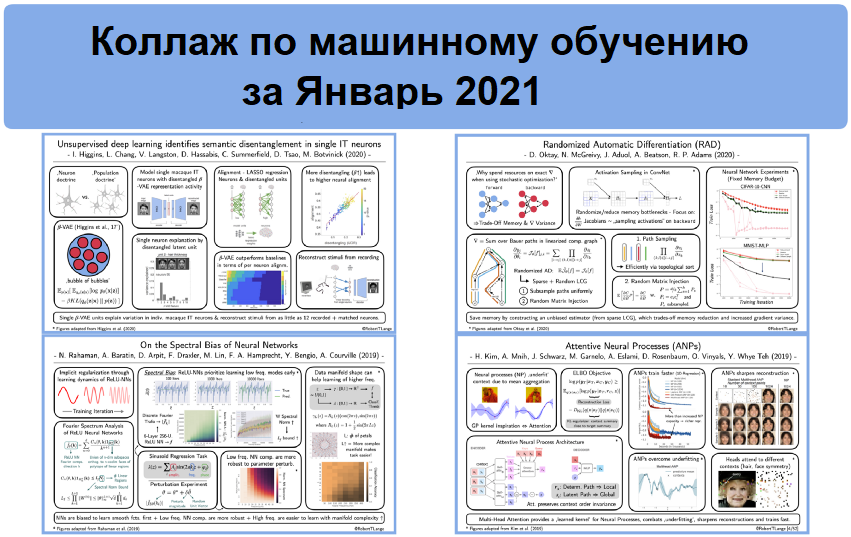

Поэтому я рад представить вам серию "Коллаж по машинному обучению". В этой серии я буду каждую неделю выкладывать обзор одной из моих любимых статей по машинному обучению в виде одного слайда. А в конце месяца я буду собирать все эти коллажи в один обзорный пост блога. Вы читаете самый первый выпуск этого блога. Итак, вот четыре научные статьи о машинном обучении, которые я прочитал в январе 2021, и которые понравились мне больше всего. Я также расскажу, почему я считаю эти статьи важными.

"Глубокое обучение без учителя определяет семантическое разделение в одиночных нейронах нижней височной доли"

Авторы: Хиггинс и пр. (2020). Ссылки: статья.

Аннотация в одном абзаце: "нейронная доктрина", провозглашенная Рамоном-и-Кахалем, утверждает, что нервная система состоит из отдельных дискретных отделов. Это привело к особому вниманию, уделяемому нейронам, занимающими центральное место в когнитивных вычислениях. С тех пор клеточная нейронаука быстро перешла от отдельных клеток к записи целых популяций, и все больше и больше работ фокусируются на глубинной коллективной динамике нейронных популяций. По мере изменения фокуса исследований в нейронауке "нейронную доктрину" затмила новая доктрина популяций. Хиггинс и пр. (2020) делают шаг назад к старым временам и исследуют, как можно смоделировать записи отдельного нейрона в нижней височной доли макаки с помощью скрытого кода вариационных автоэнкодеров (VAE). Они обнаружили, что отдельные скрытые отделы могут очень хорошо объяснить большую часть разброса активности одиночной клетки при изменении различных семантических признаков визуального стимула. Далее, они обнаружили, что повышенное разделение приводит к лучшему обучению нейронных данных. Это доказывает, что нейроны нижней височной доли могут иметь особую функцию: разделение семантических визуальных концепций. Наконец, Хиггинс и пр. (2020) показывают, что вариационные автоэнкодеры, обученные на лицах, фактически могут реконструировать визуальные стимулы, основываясь на очень ограниченных нейронных записях (до 12 нейронов).

![Коллаж машинного обучения [1/52]: адаптированные рисунки из <a href="https://arxiv.org/abs/2006.14304" target="_blank" rel="noopener noreferrer nofollow">статьи Хиггинс и пр. (2020)</a>](https://media.proglib.io/posts/2021/02/12/4f6c7dd095c825d0a8e355d210d5dfc1.png)

"Рандомизированное автоматическое дифференцирование"

Авторы: Октей и пр. (2020). Ссылки: статья, обсуждение и код.

Аннотация в одном абзаце: автоматическое дифференцирование (AD) в обратном режиме, также известное как "обратное распространение" (backpropagation) – краеугольный камень современного успеха глубокого обучения. Мы рассчитываем градиенты, используя цепное правило, линеаризированные графы вычислений, определяемые моделью, дифференцируемую целевую функцию... и случайно выбранные мини-наборы данных (batch). То есть, в конечном счете мы полагаемся всего лишь на стохастическую оценку. С точки зрения статистики, это не является проблемой, и, фактически, люди давно выступали за неявную регуляризацию, вносимую стохастическим градиентным спуском. Но можем ли мы сократить количество памяти, требуемое для обратного распространения, если полностью погрузимся в случайность? Октей и пр. (2020) предлагают две рандомизированные модификации:

- Субдискретизация так называемых "путей Бауэра", проходящих от графа вычислений.

- Внедрение случайных матриц в тех локациях, где рассчитанные якобианы требуют слишком много памяти.

Получающиеся в результате оценки градиента не имеют смещения, но приводят к повышенной диcперсии, что является платой за сокращение требуемого объема памяти. Рандомизированный алгоритм AD, предлагаемый авторами, превосходит классическое AD при заданном объеме памяти на всех классических задачах MLP, CNN и RNN, и может использоваться для многих других задач.

![Коллаж машинного обучения [2/52]: адаптированные рисунки из <a href="https://arxiv.org/abs/2007.10412" target="_blank" rel="noopener noreferrer nofollow">статьи Октея и пр. (2020)</a>](https://media.proglib.io/posts/2021/02/12/fa1e6d12060bb96d60290b214da85267.png)

"О спектральном смещении нейронных сетей"

Авторы: Рахаман и пр. (2019). Ссылки: статья и код.

Аннотация в одном абзаце: нейронные сети ReLU – универсальные аппроксиматоры функций. Но каким функциям сети ReLU "любят" обучаться, и как динамика обучения регуляризирует пространство обученных функций? Рахаман и пр. (2019) используют анализ Фурье, чтобы показать, что они имеют смещение, и в первую очередь пытаются изучать низкочастотные функции. Они предоставляют как точный аналитический спектральный анализ сетей ReLU прямого прохода, так и интерпретируемую верхнюю границу. Изученные компоненты Фурье зависят от спектральной нормы весов, и авторы обнаружили, что эта норма (а следовательно, и самая высокая изученная частота) увеличивается по мере обучения. Более того, они эмпирически показали, что низкочастотные компоненты гораздо более устойчивы к случайной пертурбации параметров. Они проверили свои догадки на простой синусоиде и задачах регрессии на наборе MNIST. Наконец, они представляют задачу классификации лепестков, которая показывает, что сложность многообразия данных может оказать критическое влияние на сложность обучения. Многие сложные многообразия могут стать намного проще в пространстве Фурье. Это окажет влияние на разработку состязательной устойчивости и на последовательное обучение (curriculum learning).

![Коллаж машинного обучения [3/52]: адаптированные рисунки из <a href="https://arxiv.org/abs/1806.08734" target="_blank" rel="noopener noreferrer nofollow">статьи Рахамана и пр. (2019)</a>](https://media.proglib.io/posts/2021/02/12/c75bb30fbea8252bf905900f2066805e.png)

"Внимательные нейронные процессы"

Авторы: Ким и пр. (2019). Ссылки: статья, обсуждение и код.

Аннотация в одном абзаце: нейронные процессы (NP) обучаются сопоставлять контекстным данным распределение функций регрессии. Такое сопоставление принято моделировать архитектурами авто-энкодера, сохраняющего инвариантность порядка. Эта архитектура разделяет детерминистский путь вывода, захватывающий локальную структуру контекста, и второй, скрытый путь, моделирующий глобальную структуру, ассоциируемую со стохастическим процессом, лежащим в основе. Чтобы собрать воедино индивидуальные элементы контекста, NP берет среднее значение по детерминистским представлениям (embeddings). Ким и пр. (2019) считают, что это приводит к потере данных и недообучению контекста. Вместо этого они предлагают использовать механизм внимания (attention), чтобы эффективно изучить параметризованную функцию ядра для NP. Они показывают, что введение внимания повышает вычислительную сложность одного прохода, но, несмотря на это, общее время, требуемое для получения хорошего решения, существенно сокращается. Более того, восстановление изображений из нескольких пикселей может выдавать острые визуальные впечатления. Как часто указывается в других статьях про внимание, авторы сообщают, что при использовании нескольких головок внимания различные головки обращают внимание на разные ключевые элементы контекста.

![Коллаж машинного обучения [4/52]: адаптированные рисунки из <a href="https://arxiv.org/abs/1901.05761" target="_blank" rel="noopener noreferrer nofollow">статьи Кима и пр. (2019)</a>](https://media.proglib.io/posts/2021/02/12/d8215c2a25ed31c51f0d03c6b290cf5e.png)

Вот и все на этот месяц. Если вы хотите следить за "коллажем машинного обучения" каждую неделю, используйте хештэг #mlcollage в Твиттере.

Комментарии