DBRX устанавливает новый уровень качества для открытых языковых моделей

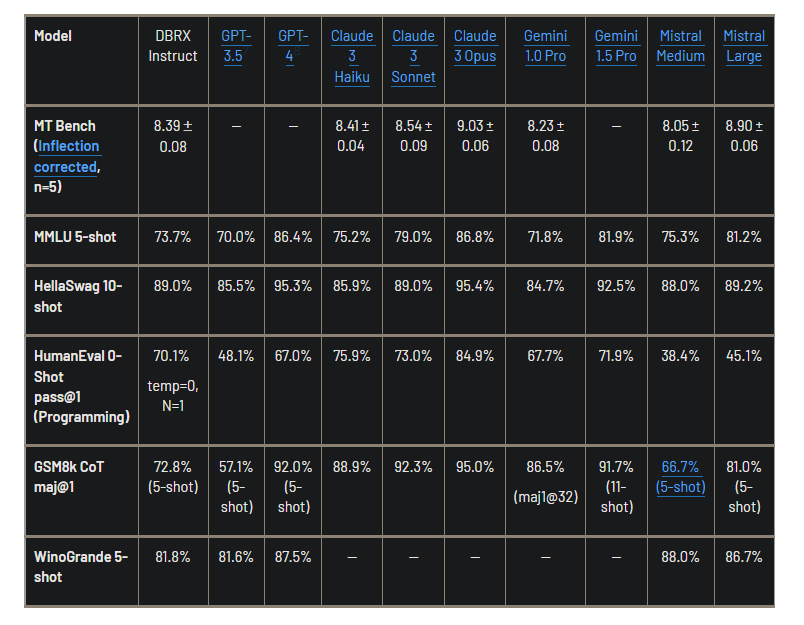

- Превосходит GPT-3.5 и конкурирует с Gemini 1.0 Pro в стандартных тестах.

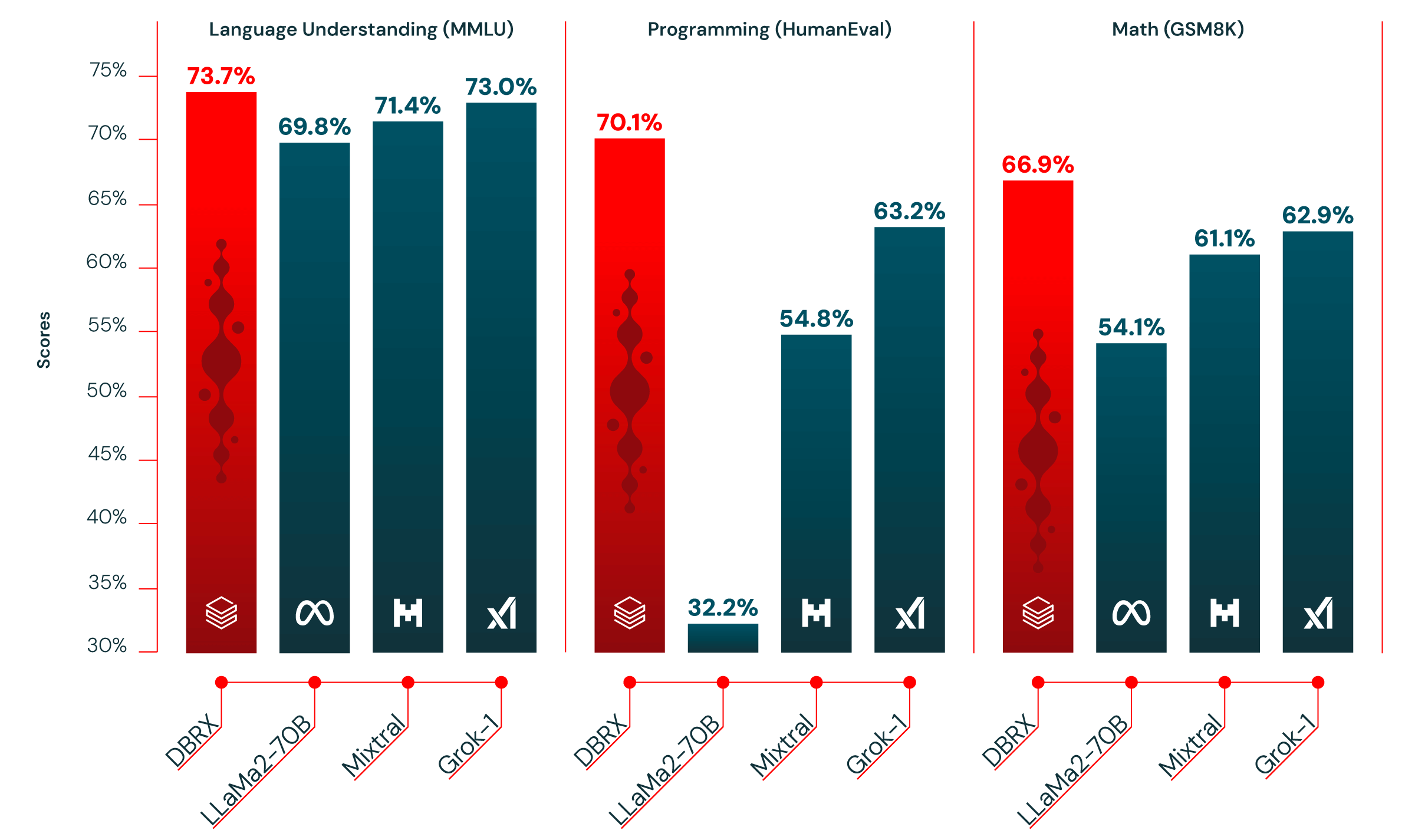

- Лидирует в тестах на MMLU, HumanEval и GSM8K.

- Опережает специализированные модели вроде CodeLLaMA-70B в написании кода.

🤖✍️ Библиотека нейротекста

Все самое полезное про ИИ-помощников вроде ChatGPT, Gemini, Bing и других вы найдете на нашем телеграм-канале «Библиотека нейротекста»

Прорыв в производительности обучения и вывода благодаря архитектуре MoE

- Вывод до 2-х раз быстрее чем у LLaMA2-70B.

- На 60% компактнее Grok-1.

- Генерация текста до 150 токенов/сек на пользователя на Mosaic AI Model Serving.

- Обучение MoE моделей в 2 раза эффективнее с точки зрения FLOP при том же качестве.

Databricks открывает доступ к DBRX для сообщества и корпоративных клиентов

- Веса базовой (DBRX Base) и дообученной (DBRX Instruct) моделей доступны на Hugging Face.

- Заказчики Databricks могут использовать DBRX через API и дообучать собственные модели.

- DBRX уже интегрируется в продукты Databricks на базе GenAI, показывая результаты на уровне GPT-4.

Комментарии