Введение

Языковая модель GPT4 от OpenAI потрясла весь мир и в одно мгновение перевернула представление о возможностях и ограничениях систем обработки естественного языка (NLP). Она способна создавать текст, который сложно отличить от написанного человеком, и делает это гораздо быстрее и качественнее, чем более ранние модели. Модель GPT4 открыла новые возможности для анализа данных, создания контента и принятия решений и вызвала переворот во многих отраслях — от маркетинга до здравоохранения и обороны.

Неудивительно, что миллионы специалистов и энтузиастов по всему миру с нетерпением ждут, что будет дальше с технологиями искусственного интеллекта, и строят предположения о том, какие возможности откроются в следующей версии. Чтобы лучше понять, что нас может ждать в ближайшем будущем, в этой статье я собрал всю известную информацию о предстоящем релизе GPT-5, а также о других прорывных ИИ-решениях.

Что сейчас происходит с технологиями ИИ?

Пожалуй, одна из наиболее известных ИИ-моделей — это GPT-4. Чаще всего именно она ассоциируется с инновациями и достижениями в сфере искусственного интеллекта. Давайте рассмотрим ее подробнее, чтобы лучше представлять, чего нам ждать от следующей версии.

Технические характеристики GPT-4

Четвертое поколение GPT (Generative Pre-trained Transformer, генеративный предобученный трансформер) показало гораздо более высокие результаты в понимании и генерации естественного текста.

В OpenAI не раскрывают точный объем GPT-4, но считается, что он значительно больше, чем у предыдущей версии, GPT-3. Она насчитывала 175 миллиардов параметров, что уже очень впечатляет.

Модель GPT-4 обучена на огромном наборе данных, который включает в себя онлайн-источники, книги, статьи и образовательные материалы, опубликованные до 2023 года. Благодаря этому, модель способна работать с широким кругом тем и демонстрировать исключительную точность и высокую релевантность.

Модель GPT-4 занимает одну из лидирующих позиций по объему информации, которую она может учитывать при генерации ответа. Размер контекстного окна GPT-4 Turbo — 128 тысяч токенов (минимальных единиц обработки текстовой модели), в восемь раз больше, чем у GPT-3.5, у которой контекстное окно насчитывает 16 тысяч токенов. Это значит, что для выдачи ответа GPT-4 обрабатывает примерно 300 страниц текста.

Возможности GPT-4

Благодаря техническим улучшениям, GPT-4 значительно продвинулась в понимании и генерации естественного языка, переводе, создании контента и написании кода.

Модель прекрасно улавливает контекст и генерирует текст, практически неотличимый от написанного человеком. Она может поддерживать подробный диалог, отвечать на сложные вопросы, давать объяснения и делать выводы с пониманием тонких языковых нюансов.

Возможности GPT-4 положили начало новой эре создания контента: теперь ИИ-модель может писать эссе, статьи, рассказы и даже стихи. Она может адаптироваться под нужный тон и стиль и подражать конкретным авторам. Это делает GPT-4 гибким и удобным инструментом для писателей и создателей контента. Впечатляют и возможности перевода: модель легко справляется с несколькими языками, понимает грамматику, идиомы и культурные контексты, позволяя людям легко преодолевать языковые барьеры. Более того, GPT-4 может писать, отлаживать и объяснять код на различных языках программирования, упрощая сложные концепции и повышая производительность разработки ПО.

Когда ждать новую GPT-модель?

Дата релиза

У следующей модели GPT пока нет конкретной даты релиза, но известно, что OpenAI активно над ней работает. CEO компании, Сэм Альтман, подтвердил изданию Financial Times в ноябре 2023 года, что команды заняты разработкой новой модели, но не уточнил, когда она увидит свет.

В своем выступлении на Всемирном правительственном саммите (WGS) в феврале этого года он заявил, что OpenAI «не планирует торопиться» с выпуском новой модели, стремится подойти к разработке со всей ответственностью и создать продукт, которым компания сможет гордиться.

Согласно графику релизов прошлых моделей, между выпуском GPT-3 в июне 2020 и GPT-4 в марте 2023 прошло чуть менее трех лет. Если компания будет придерживаться такого же темпа, GPT-5 увидит свет в 2025 году.

Название

Неизвестна не только дата выхода, но и то, выйдет ли новая модель GPT под номером 5.

Несмотря на то что 18 июля 2023 года OpenAI подала заявку на торговую марку GPT-5 в Ведомство по патентам и товарным знакам США, ходят слухи, что компания может выпустить промежуточный релиз, GPT-4.5, как это было после GPT-3.

В интервью Bloomberg Сэм Альтман ответил на слухи о названии следующей модели GPT: «Я не знаю, как мы назовем нашу следующую модель... Я не хочу, чтобы это воспринималось как релиз iPhone 27... Мы не планируем торопиться (с разработкой)».

Что сейчас известно о релизе GPT-5?

Несмотря на всю секретность по поводу релиза GPT-5, Сэм Альтман все же рассказал о том, какие улучшения будут в грядущей модели на Всемирном правительственном саммите и в подкасте Билла Гейтса под названием Unconfuse Me в январе этого года. Вот некоторые предположения:

Быстрее и умнее

Выступая на Всемирном правительственном саммите в январе, Сэм Альтман заявил, что самое важное, что нужно знать о следующей модели GPT — это то, что она будет «умнее», и от этого «быстрее» и «лучше по всем параметрам». «Магия этих ИИ-моделей в том, что они универсальные. Поэтому, если они будут умнее, значит, они будут немного лучше во всем», — добавил он.

Работа с изображениями, аудио и видео

«Мультимодальность — это важно», заявил Альтман в подкасте у Билла Гейтса, указывая на то, что OpenAI добавит разнообразные типы контента — изображения, аудио, видео и числовые данные, а не только текст.

У GPT-4 уже есть некоторые черты мультимодальной модели — она способна обрабатывать не только текст, но и изображения, хотя на выходе может выдавать только текст.

«Добавив изображения и аудио [в GPT-4], мы получили гораздо больший отклик от пользователей, чем ожидали. Мы можем продвинуться в этом направлении гораздо дальше» — добавил Альтман в подкасте.

Улучшенная персонализация

Альтман также отметил, что для новой версии «будут очень важны настраиваемость и персонализация», поэтому модель будет использовать личные данные: электронную почту, данные календаря, предпочтения в планировании встреч. Еще одним ключевым улучшением будет возможность интеграции с внешними источниками данных.

«Люди стремятся получить от GPT-4 совершенно разные результаты, в разном стиле и разным набором предположений. Мы сделаем все это возможным.» — добавил он.

Более качественная аргументация

«Наиболее важные улучшения, вероятно, будут связаны с умением анализировать» — подчеркнул Альтман, имея в виду способность моделей ИИ интерпретировать информацию, делать выводы, принимать решения и решать проблемы, используя имеющиеся данные и логические умозаключения.

Анонс Gemini 1.5 от Google: каким трендам последует GPT-5?

Хотя Сэм Альман и поделился некоторыми идеями о новой GPT-модели, он, как обычно, не раскрывает раньше времени технические подробности. Тем не менее, недавние релизы от других разработчиков могут помочь понять масштаб улучшений, который нас ждет. 15 февраля одна из лидирующих ИИ-компаний, Google DeepMind, анонсировала релиз новой усовершенствованной модели Gemini 1.5 Pro. Это будет мультимодальная модель среднего размера, предназначенная для масштабирования на широкий спектр задач. Ее производительность сравнима с 1.0 Ultra, самой мощной моделью Google на сегодняшний день. В Google прокомментировали некоторые технические подробности, по которым мы можем определить, насколько далеко модель продвинулась вперед относительно предыдущих версий. Вот несколько основных изменений:

Архитектура

Gemini 1.5 будет обучать и обслуживать с большей эффективностью, поскольку модель сочетает в себе архитектуры Transformer и Mixture-of-Experts (MoE). Традиционный трансформер функционирует как одна большая нейронная сеть, в то время как MoE состоит из множества «экспертных» нейронных сетей. Модели MoE учатся активировать только наиболее релевантные экспертные пути в своих нейронных сетях, что значительно повышает производительность модели. Такая архитектура позволяет Gemini 1.5 быстрее обучаться сложным задачам при сохранении качества.

Контекст

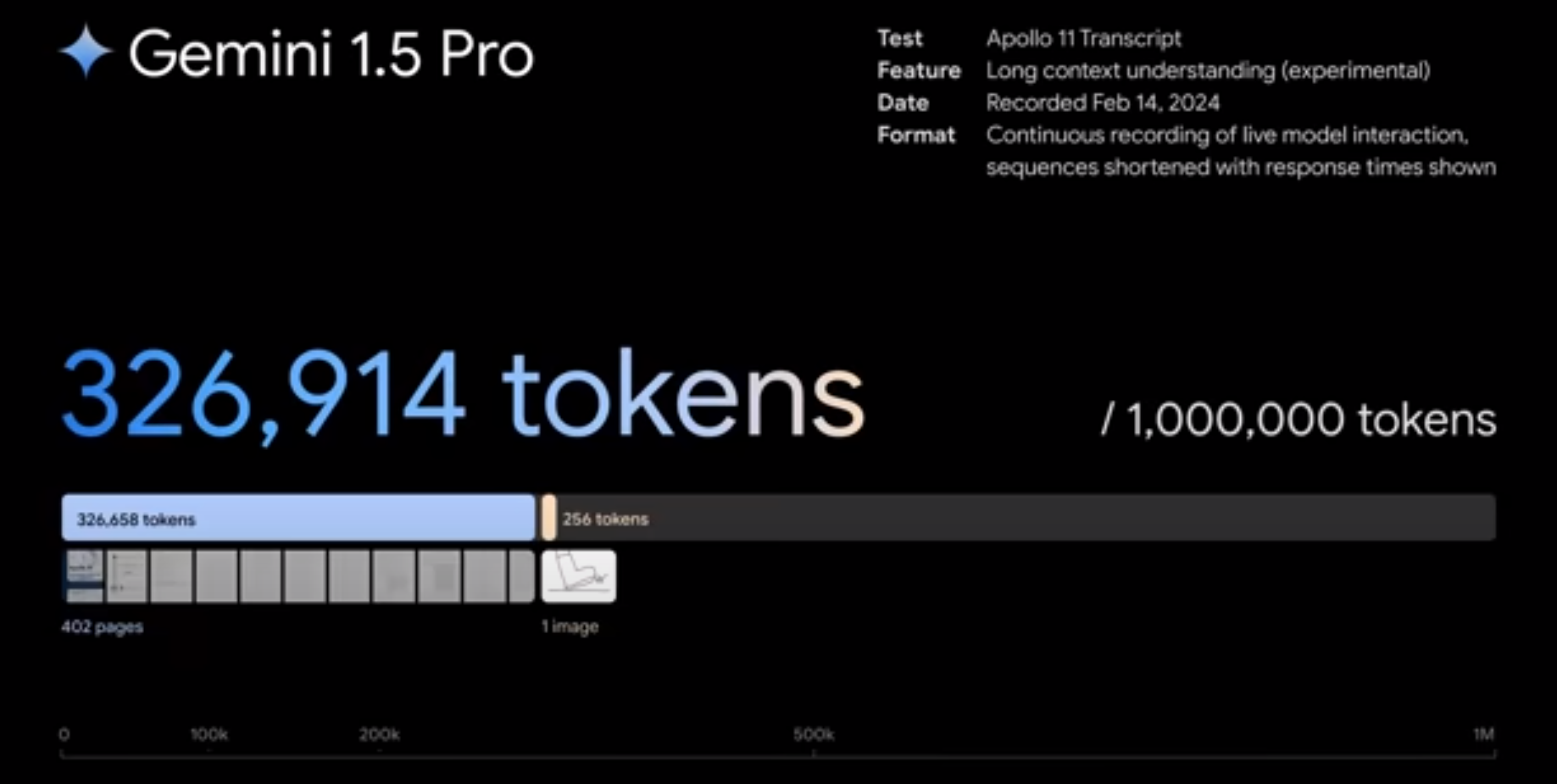

Новая модель также включает в себя экспериментальную функцию, которая произвела настоящую революцию в понимании объемных контекстов. Для сравнения, GPT-4 Turbo способна обрабатывать контекст из 128 тысяч лексем, а емкость контекстного окна 1.5 Pro составляет миллион лексем. Это позволяет 1.5 Pro обрабатывать огромные объемы данных за раз, например, один час видео, 11 часов аудио, кодовые базы, содержащие более 30 000 строк кода, или текст объемом 700 000 слов.

Аргументация

Аналитические возможности 1.5 Pro тоже впечатляют: модель будет способна анализировать, классифицировать и обобщать большие объемы контента в рамках одного запроса. Например, проанализировав стенограмму лунной миссии «Аполлон-11» в которой 402 страницы, 1.5 Pro сможет рассуждать обо всех переговорах, событиях и деталях.

Мультимодальность

1.5 Pro крайне эффективно справляется с задачами на понимание и анализ видео и подобных форматов. Например, модель может точно определить и прокомментировать события и элементы сюжета в 44-минутном немом фильме Бастера Китона.

Производительность

Gemini 1.5 Pro способна находить нужный фрагмент встроенного текста текст в 99% случаев в блоках данных длиной до 1 миллиона лексем. Это подтверждается тестом NIAH (Needle In A Haystack, или «иголка в стоге сена»), в котором небольшой фрагмент текста, содержащий конкретный факт или утверждение, целенаправленно помещается в большой блок текста.

Обучаемость

1.5 Pro может обучаться новым способностям, если предоставить ей информацию через длинный текстовый запрос. К примеру, проанализировав учебник грамматики языка каламанг, на котором говорят менее 200 человек по всему миру, модель научилась выполнять качественный перевод с английского на этот язык.

Вывод

Несмотря на то, что в технологии еще много белых пятен, GPT-5 с большой вероятностью станет большим шагом вперед в эволюции языковых ИИ-моделей. Каждая последующая модель включает в себя сильные стороны предыдущей; так будет и с GPT-5. Скорее всего, новая модель поможет еще больше расширить человеческие возможности с помощью функций, о которых нам еще предстоит узнать.

Комментарии