Не понимаю, с помощью каких методов мы оцениваем качество предсказаний модели. Слышал, что в этом случае может помочь F-score, но какая идея стоит за этой метрикой?

Качество предсказаний модели зависит от точности.

Предположим, что у нас есть радар, цель которого – обнаружить самолет среди других летающих объектов. У этого действия есть несколько конечных исходов.

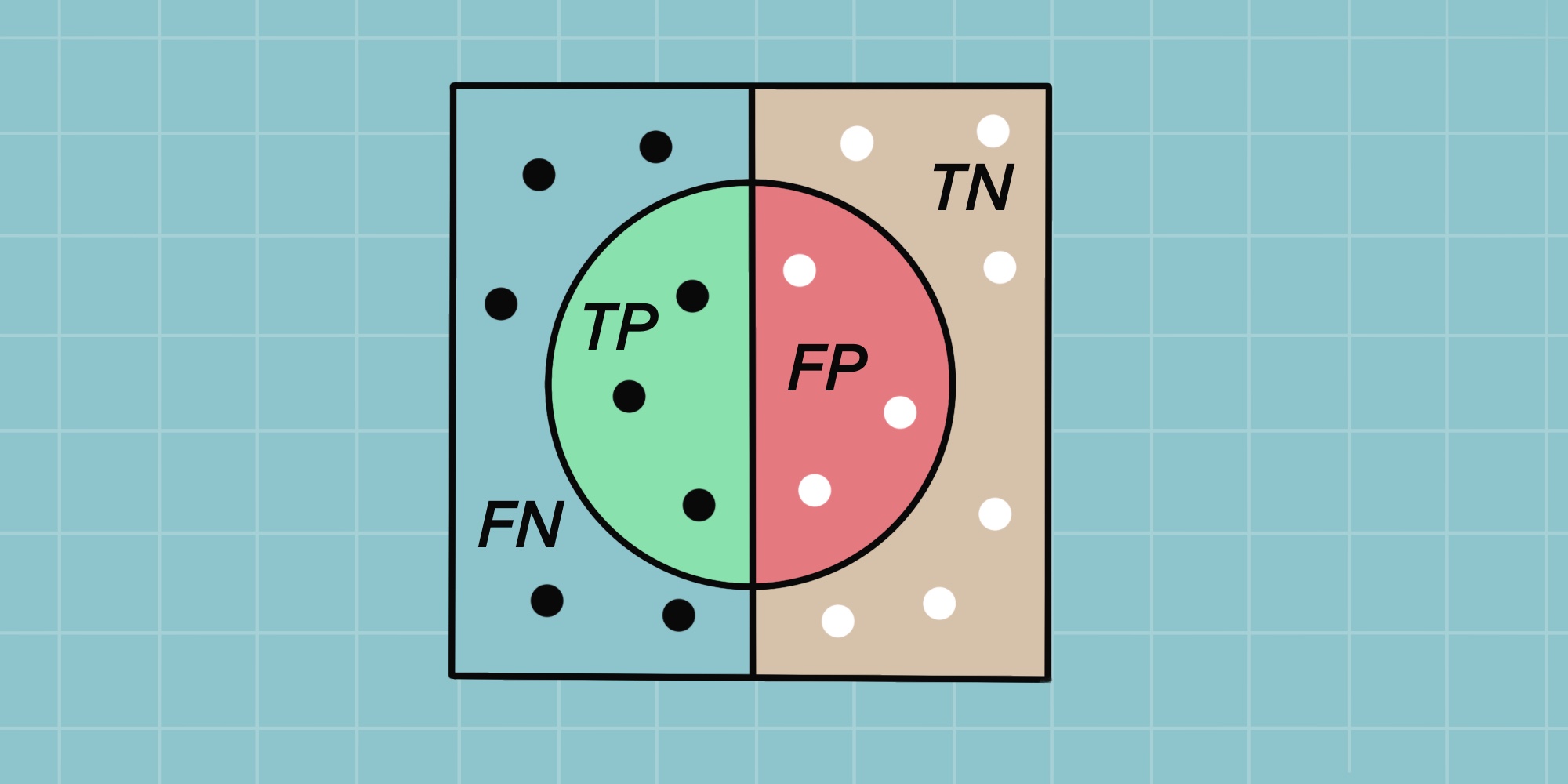

Введем следующие обозначения:

- TP (True Positive) – истинно-положительное решение. Самолет обнаружен.

- TN (True Negative) – истинно-отрицательное решение. Мы не стали детектировать объект, который является бабочкой.

- FP (False Positive) – ложно-положительное решение. Мы определили другой объект (птицу) как самолет.

- FN (False Negative) – ложно-отрицательное решение. Мы не стали детектировать объект, но он оказался самолетом.

- Precision (точность) – насколько хорошо мы находим цель, не “переплачивая” за это ненужными False срабатываниями.

- Recall (полнота) – как правильно мы обнаружим все True examples.

Цель – минимизация ложно-отрицательного решения, которое делает наше значение менее точным.

Упрощая: Precision – не прихватить лишнее. Recall – не пропустить нужное.

Очевидно, что чем выше Precision (точность) и Recall (полнота), тем лучше. Однако, в реальной жизни невозможно достичь максимума обоих показателей одновременно. Нам приходится искать баланс.

Таким образом, необходима метрика, которая объединяет в себе информацию о точности и полноте нашего алгоритма. Ей является F-score (в иных случаях обозначается как F-measure).

Комментарии